Droit, technologies & prospectives

Tous les mois, toute l'actualité du numérique... Et tellement plus !

Nos derniers numéros

N°457 – mai 2020

N°457 – mai 2020 N°456 – avril 2020

N°456 – avril 2020 N°455 – mars 2020

N°455 – mars 2020 N°454 – février 2020

N°454 – février 2020

N°452 – décembre 2019

N°452 – décembre 2019 N°451 – novembre 2019

N°451 – novembre 2019 N°450 – octobre 2019

N°450 – octobre 2019 N°449 – septembre 2019

N°449 – septembre 2019 N°448 – juillet 2019

N°448 – juillet 2019

Sommaire

Edito

Focus

En bref

L’information rapide sur le monde du numérique

Magazine

L’information légale et jurisprudentielle du numérique

Interview

Doctrines

IA agentique au travail : nouveaux risques, nouvelles règles ?

Nouvel arsenal réglementaire pour les prestataires SaaS

« Augmenter » les professions du droit avec l’IA

Rançongiciel : un hôpital sanctionné pour manquement à la sécurité de ses données

La protection des données sensibles de l’état sur le marché du cloud

Viginum : un service protecteur du débat public numérique

L'édito du mois

Chamboule tout règlementaire

Un vent de déréglementation souffle sur l’Europe, au nom d’une nouvelle stratégie de simplification pour booster l’innovation face à la concurrence américaine et chinoise. Le dernier jour du sommet mondial pour l’IA, soit le 11 février 2025, la Commission européenne a rendu public son programme de travail 2025 dans lequel on apprenait le retrait de 37 propositions de textes dont quatre relatives au numérique : le règlement sur la vie privée et les communications électroniques (visant à remplacer la directive actuelle sur la vie privée et les communications électroniques), la directive sur la responsabilité de l’IA (visant à compléter la nouvelle directive sur la responsabilité du fait des produits), le règlement sur les brevets essentiels et FiDA (Financial Data Access), le texte qui devait permettre de partager les données des clients entre les institutions financières et favoriser « l’open finance ». Motif invoqué : l’absence de consensus pour leur adoption.

La proposition de directive 2022/0303 devait instaurer un régime de responsabilité civile extracontractuelle en matière d’intelligence artificielle. Elle devait remédier à la difficulté de prouver la faute des fournisseurs d’IA en instaurant le renversement de la charge de la preuve, qui devait peser sur les fabricants de systèmes d’IA. L’Europe a-t-elle eu peur de « sur-réglementer » ? L’eurodéputé Axel Voss (PPE), rapporteur du projet de règlement, a fustigé la Commission qui privilégierait « l’insécurité juridique, les déséquilibres de pouvoir en faveur des entreprises et une approche digne du Far West qui ne profite qu’aux grandes entreprises technologiques ». De son côté, l’avocate Alexandra Iteanu explique que « dans le silence de la loi, nul ne doute que ces questions seront réglées dans les contrats avec ces fournisseurs d’IA, les fameuses « Conditions générales », qui sont des contrats d’adhésion très difficilement négociables ».

Comme pour le texte sur la responsabilité de l’IA, le règlement ePrivacy n’était guère consensuel. Après huit ans de discussions infructueuses, la Commission a jeté l’éponge au grand soulagement des fournisseurs. « La proposition est dépassée au vu de certaines législations récentes, tant dans le technologique et législatif », a expliqué la Commission. On en reste donc avec une directive de 2002 révisée en 2009. Pour FiDA contre lequel les assureurs étaient vent debout, c’est l’argument de la simplification administrative qui a été mis en avant par Bruxelles pour expliquer le retrait du texte au grand dam des fintechs qui attendaient l’ouverture des données financières.

Le retrait de la proposition de règlement sur les brevets essentiels standards a par ailleurs provoqué la « stupéfaction » de la Fair Standards Alliance, une organisation industrielle plaidant en faveur de l’octroi de licences pour des technologies normalisées (telles que la 5G ou le Wi-Fi) à des conditions équitables, raisonnables et non discriminatoires. Selon elle, cette décision « va à l’encontre de l’appel de M. Draghi à placer l’innovation au centre de la quête de compétitivité de l’Europe et à éliminer les obstacles qui entravent l’innovation des industries fortes de l’Europe ».

La réglementation n’est plus un objet de fierté européenne mais un concept repoussoir. Le revirement de la Commission en faveur de son allègement a été salué par la CCIA Europe, qui représente les grandes entreprises technologiques. Quant aux représentants des utilisateurs et les Fintechs pour FiDA, ils ne cachent pas leur amertume. S’agit-il d’un allègement réglementaire pour rendre notre économie plus compétitive ou d’un véritable revirement aligné sur la doxa américaine ?

Le focus du mois

L’IA fait parler les morts

Dialoguer avec les morts est désormais possible grâce aux deadbots, ces agents conversationnels entraînés avec les données laissées par les défunts. Le droit ne s’est pas encore saisi de cette technologie qui comporte pourtant des risques pour les vivants comme pour les morts.

De tout temps, l’être humain à cherché à entrer en contact et à s’entretenir avec les défunts. Aujourd’hui, la technologie rend possible et tangible ce rêve millénaire grâce au couplage de l’intelligence artificielle générative et des données personnelles de la personne décédée. Ainsi ce jumeau numérique constitué de la voix, de l’image et des données textuelles du disparu pourra dialoguer avec les vivants en simulant son style et sa personnalité. Une illusion de réalité troublante. Dès 2021, le Comité national pilote d’éthique du numérique (CNPEN(*)) a émis un avis sur les enjeux éthiques des agents conversationnels dans lequel il s’est penché sur ce phénomène émergeant. Il a pointé les dangers pour les vivants et pour les morts tout en suggérant des évolutions du cadre légal. Depuis, le droit ne s’est pas saisi de la question. Pourtant si les offres de la death tech s’adressent essentiellement à un public américain et asiatique, elles devraient s’étendre ; le marché de l’immortalité numérique s’annonce prospère.

À partir de 2020, diverses expériences de deadbot font parler d’elles. Une des histoires les plus connues concerne un Canadien qui ne s’étant jamais remis du décès brutal d’une femme. Il a conçu un chatbot à l’aide de ChatGPT-3 d’OpenAI et l’a entraîné avec les messages qu’il avait conservé de sa petite amie, reproduisant ses expressions. « Le chatbot semblait percevoir les émotions. Il savait comment dire une phrase juste, au bon moment et en mettant le bon accent », expliquera-t-il. L’entreprise coréenne DeepBrain AI est allée plus loin en développant le service re;memory, qui propose un hologramme du proche disparu avec lequel on peut continuer à discuter. Microsoft, de son côté, a déposé un brevet combinant un agent conversationnel de type GPT, à partir des données de la personne : images, voix, publications sur les réseaux sociaux, SMS, courriels, etc.

Au lieu d’utiliser les données du défunt « à son insu », d’autres sociétés offrent aux vivants la possibilité de préparer eux-mêmes leur deadbot, anticipant leur fin. Ainsi, c’est eux qui communiquent les données destinées à l’entraînement de leur « double » numérique. Le client peut ainsi choisir les pensées qu’il entend laisser en héritage, de sorte que le deadbot pourra entretenir une conversation dans le cadre fixé par le futur défunt, sans avoir la possibilité d’inventer des propos.

Comme l’a indiqué une étude du Leverhulme Centre for the Future of Intelligence (LCFI) de Cambridge, « ce domaine de l’IA est un véritable champ de mines éthiques ». Pas étonnant que le CNPEN se soit emparé du phénomène d’une nature sans précédent. Le deadbot ne se contente pas de ressortir les mots et la voix de la personne décédée, il est capable de proférer des paroles jamais tenues de son vivant, à partir des données récoltées. Il peut avoir un dialogue très vraisemblable, favorisé éventuellement par la capacité de simulation d’émotions. Le proche peut ainsi avoir l’impression de se trouver en présence du défunt ainsi imité, même s’il est explicitement informé qu’il s’agit d’une machine.

Pour le Comité, ce n’est pas sans danger pour la santé mentale des vivants et peut produire une altération du jugement. Surtout il pointe la question du respect de la dignité des morts et de leur consentement quand ils ne sont pas à l’initiative de la création de leur double numérique. L’article 85 de la loi Informatique et libertés prévoit que « toute personne peut définir des directives relatives à la conservation, à l’effacement et à la communication de ses données à caractère personnel après son décès ». Et en l’absence de directives, les héritiers peuvent exercer certains droits mais dans la perspective de la succession. De façon générale, le RGPD n’est pas applicable aux personnes décédées comme le droit au respect de sa vie privée, la mort entraînant la fin de la personnalité juridique. Une décision du 7 juin 2017 du Conseil d’État rappelle d’ailleurs que les héritiers ne sont par principe pas des personnes concernées.

De même, l’article 226-4-1 du code pénal qui sanctionne l’usurpation d’identité ne s’applique qu’aux personnes vivantes. Or, le risque d’une telle usurpation ou de création d’un deepfake par un agent conversationnel existe réellement. Le CNPEN en conclut que « les concepteurs de deadbots doivent respecter la dignité de la personne humaine qui ne s’éteint pas avec la mort, tout en veillant à préserver la santé mentale des utilisateurs de tels agents conversationnels. Des règles doivent être définies concernant notamment le consentement de la personne décédée, le recueil et la réutilisation de ses données, le temps de fonctionnement d’un tel chatbot, le lexique utilisé, le nom qui lui est attribué ou encore les conditions particulières de son utilisation ». Plus spécifiquement, le Comité estime que « le législateur devrait adopter une réglementation spécifique concernant les agents conversationnels qui imitent la parole des personnes concernées ».

L’immortalité numérique repose sur le traitement des données laissées par les défunts. Ces données représentent une ressource inexploitée qu’une nouvelle économie cherche à investir. Des garde-fous pour protéger la dignité et la mémoire des morts restent à imaginer.

L'invité du mois

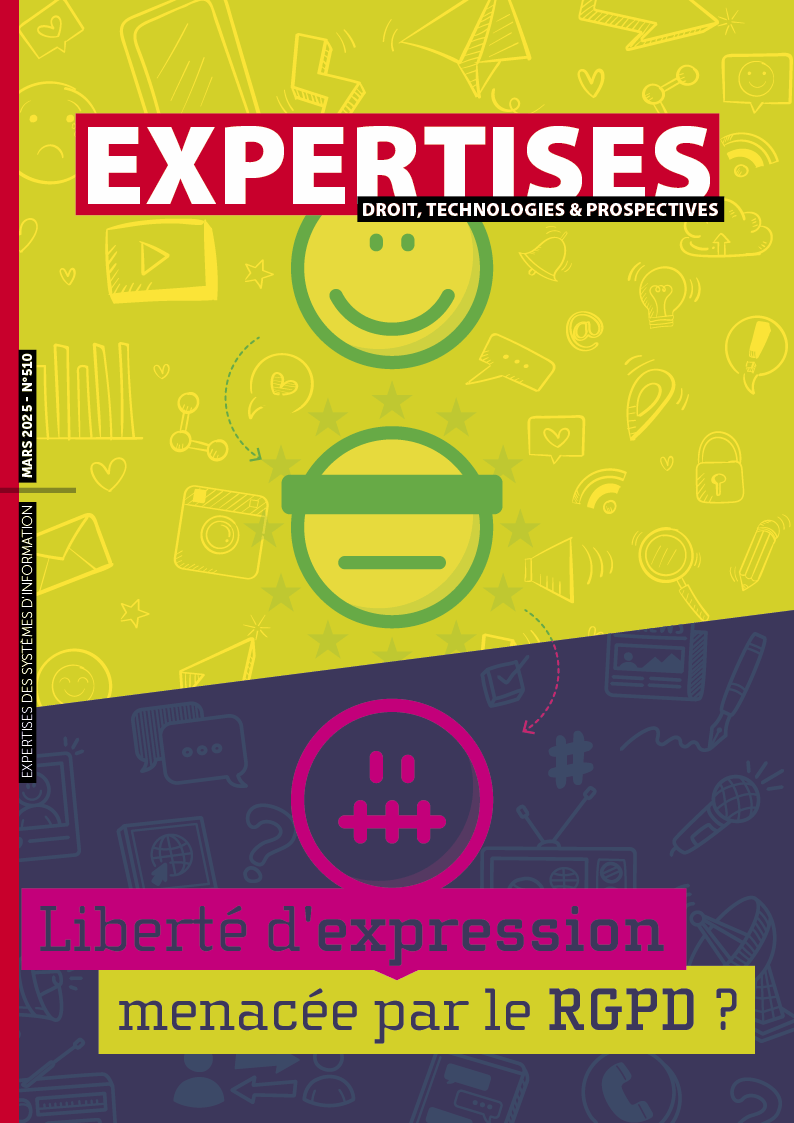

Interview / Alexandre Fiévée

La liberté d’expression menacée par le RGPD ?

Surtout depuis internet, deux visions de la liberté d’expression opposent les Etats-Unis à l’Europe où celle-ci peut être limitée pour des motifs de protection de droits de la personnalité visant à éviter toute diffamation, discrimination ou atteinte excessive à la vie privée d'autrui. Depuis peu, le RGPD est invoqué par des personnes pour contester la publication d’articles les concernant. Et des autorités de contrôle européennes leur ont donné gain de cause. Les médias ne savent pas toujours que le RGPD s’applique à eux, même s’ils bénéficient de quelques dérogations. Le grand public non plus d’ailleurs. Alexandre Fiévée, avocat spécialiste en droit de la protection des données personnelles, nous dit dans quelle mesure le RGPD peut imposer des limites à la libre parole des journalistes mais aussi des particuliers.

Sylvie Rozenfeld : Internet a permis à tout le monde de s’exprimer et de diffuser sa parole librement dans des commentaires, des blogs ou sur les réseaux sociaux. Comme la presse, les personnes bénéficient de la liberté d’expression. Mais ce droit n’est pas absolu. Une des limites récemment opposée à la liberté d’expression est la protection des données personnelles. L’article 85 du RGPD prévoit que les États membres concilient, par la loi, le droit à la protection des données à caractère personnel et le droit à la liberté d’expression et d’information, y compris le traitement à des fins journalistiques et à des fins d’expression universitaire, artistique ou littéraire et qu’ils peuvent adopter des dérogations et des exemptions. Avant d’aborder la jurisprudence de la Cour de justice de l’UE et des autorités de contrôle en matière de données personnelles, j’aimerais qu’on commence sur une considération générale sur la réalité de la menace du RGPD sur la liberté d’expression.

Christophe Bigot considère qu’on assiste à une expansion hégémonique du droit des données personnelles au détriment de la liberté d’expression alors que ces droits « ne sont ni absolus ni hiérarchisés entre eux, étant d’égale valeur ». Selon lui, ce sont deux systèmes de droit reposant sur des philosophies radicalement différentes qui posent la question de leur compatibilité. Y-a-t-il une antinomie fondamentale entre la liberté d’expression, qui se fonde sur des possibilités illimitées de rassemblement et de circulation des informations et la protection des données à caractère personnel qui exige au contraire (…) de strictes limitations afin d’assurer le respect de la vie privée ?

Alexandre Fiévée : La règlementation en matière de protection des données personnelles ne limite pas la liberté d’expression. Au contraire, l’article 85 donne même la possibilité à chaque Etat membre de prévoir par la loi un régime dérogatoire pour les traitements réalisés à des fins journalistiques. Il ne s’agit donc pas de restreindre la liberté d’expression mais de à la protection des données personnelles. C’est dans ce cadre que le législateur français a ainsi écarté, pour les traitements journalistiques, certains principes du RGPD (principe de transparence, principe d’interdiction de traiter des données sensibles mais aussi des données relatives aux condamnations, etc.) et plusieurs droits reconnus aux personnes concernées (droits d’accès, de vérification, etc.).

La liberté d’expression s’applique aussi aux particuliers qui s’expriment sur leur site, blog ou sur les réseaux sociaux. Et l’article 2.2. c) prévoit que le RGPD ne s’applique pas aux traitements effectués par une personne physique dans le cadre d’une activité strictement personnelle ou domestique. Où se situe la frontière à partir de laquelle le RGPD s’applique ?

On a longtemps pensé, et certains le pensent encore, que la règlementation sur la protection des données personnelles ne s’applique pas aux traitements réalisés par des particuliers car les traitements dits « domestiques » sont exclus du champ d’application du RGPD. Or, la CJUE, tout comme certaines autorités nationales de contrôle dans l’UE, ont eu l’occasion de préciser cette notion de traitement « domestique » et ont considéré qu’elle devait se limiter aux traitements réalisés dans le cadre de la sphère privée de l’individu. Dès qu’ils débordent dans la sphère publique, ils sont soumis au RGPD. Prenons l’exemple d’un dispositif de vidéosurveillance installé à l’entrée d’une propriété privée. Si la caméra est orientée, ne serait-ce qu’en partie, vers l’espace public et si elle filme, par voie de conséquence, des personnes qui sont extérieures à la propriété, il ne s’agit pas d’un traitement domestique, mais d’un traitement soumis au RGPD avec toutes les conséquences qui en découlent. Seconde situation dans laquelle le RGPD s’applique : les données, bien que collectées par un individu dans un cercle privé, sont diffusées par celui-ci à un nombre indéfini de personnes, par exemple sur les réseaux sociaux. Dans les deux exemples susvisés, bien que les traitements soient réalisés par des particuliers, ils sont soumis au RGPD.

Mais si vous diffusez les données personnelles d’un tiers sur un réseau social sur un compte privé, le traitement, soumis au RGPD, est-il licite ?

Se pose la question de la base légale du traitement. Et la seule qui semble pouvoir s’appliquer dans cette situation est celle du consentement de la personne concernée, contrairement au journaliste, qui dans le cadre d’un article dans lequel il mentionnerait des données relatives à un tiers, pourrait, lui, se prévaloir d’un intérêt légitime. C…

Les doctrines du mois

IA agentique au travail : nouveaux risques, nouvelles règles ?

Du fait de son autonomie et de sa capacité à interagir avec des systèmes complexes, l’IA agentique recèle un potentiel de transformation significatif dans le monde du travail. Toutefois, cette évolution de l’IA comporte des risques et des défis, tant sur le plan technique, juridique qu'éthique pour lesquels l’adaptation du cadre juridique serait souhaitable.

Nouvel arsenal réglementaire pour les prestataires SaaS

Plusieurs textes dont la loi SREN, le Data Act et la directive NIS 2 imposent directement de nouvelles obligations aux prestataires SaaS, qui les contraignent à revoir certaines pratiques et leurs modèles de contrats.

« Augmenter » les professions du droit avec l’IA

L’IA générative bouleverse les pratiques juridiques : le rapport d’information sénatorial du 18 décembre 2024 sur l’IA générative présente 20 mesures pour innover sans déroger à la déontologie ni sacrifier l’intérêt du justiciable. Entre efficacité et vigilance, il dessine des premières mesures pour moderniser les professions du droit.

Rançongiciel : un hôpital sanctionné pour manquement à la sécurité de ses données

L’autorité belge de protection des données inflige une amende de 200 000 euros à un hôpital, qui avait fait l’objet d’une attaque par rançongiciel, en raison de manquements à la sécurité de ses données. La décision de l’APD établit un précédent important pour le secteur de la santé concernant les obligations des responsables de traitement en matière de cybersécurité.

La protection des données sensibles de l’état sur le marché du cloud

La doctrine « Cloud au centre » de l’Etat a pris force de loi au travers de l’article 31 de la loi SREN : ainsi et sauf dérogations qui seront nécessairement temporaires (maximum 18 mois), seul un cloud qualifié SecNumCloud est aujourd’hui envisageable pour tout projet d’un service de l’Etat qui traite des données d’une sensibilité particulière.

Viginum : un service protecteur du débat public numérique

La 19ème édition de l’université des DPO organisée par l’AFCDP1 qui s’est déroulée les 6 et 7 février 2025 à Paris a été l’occasion notamment de présenter un organisme encore peu connu ; à savoir le service de vigilance et de protection contre les ingérences numériques étrangères (Viginum) créé par décret en 20212 et placé sous l'autorité du secrétaire général de la défense et de la sécurité nationale (SGDSN).

Tous les mois, toute l'actualité du numérique... Et tellement plus !

FORMULES D'ABONNEMENT